New York.- Geoffrey Hinton Er war ein Pionier der künstlichen Intelligenz. Im Jahr 2012 entdeckte Hinton zusammen mit zwei Doktoranden der University of Toronto Künstliche Intelligenz (KI) ist eine Technologie, die zur intellektuellen Grundlage von Systemen geworden ist, die die großen Technologieunternehmen von heute als Schlüssel für ihre Zukunft ansehen.

Doch am Montag, Hinton schließt sich einem wachsenden Chor kritischer Stimmen an, die Technologiegiganten beschuldigen, in den Abgrund zu rasen.Sein intensives Bestreben, Verbraucherprodukte auf der Grundlage von generativer KI zu entwickeln, der Technologie, die beliebte Chatbots wie ChatGBT antreibt.

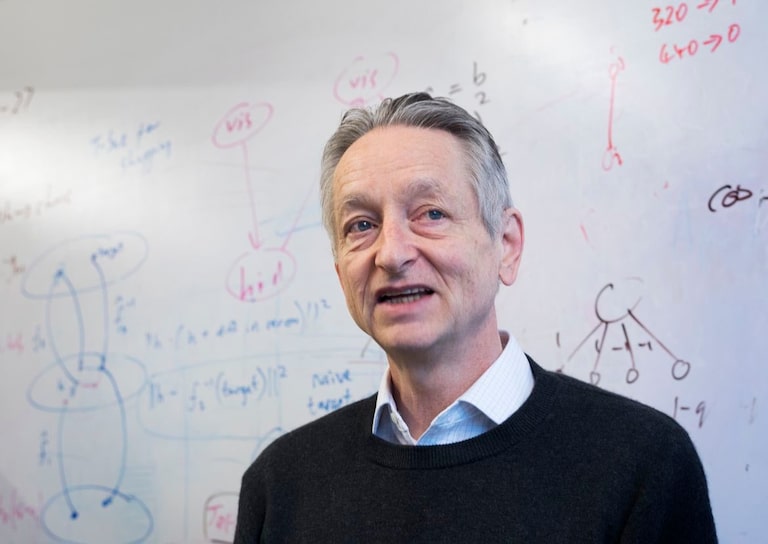

Hinton Er sagt, er habe bei Google gekündigt Er arbeitete mehr als ein Jahrzehnt daran, einer der angesehensten Stimmen in seinem Beruf zu werden. Frei über die Risiken von KI sprechen können. „Ein Teil von mir bereut mein Lebenswerk“, gibt Hinton zu.

„Ich tröste mich mit der üblichen Entschuldigung: Wenn ich es nicht gewesen wäre, hätte es jemand anderes getan“, sagt Hinton während eines langen Interviews im Speisesaal seines Hauses in Toronto, ein paar Blocks von dem Ort entfernt, an dem er und seine Schüler das gemacht haben wichtige Entdeckung.

Hintons Wende vom KI-Pionier zum Propheten der Apokalypse ist ein bedeutendes Ereignis für eine Technologiebranche, die vor dem bedeutendsten Wendepunkt seit Jahrzehnten steht. Branchenführer glauben, dass neue KI-Systeme genauso wichtig sein werden wie das Aufkommen von Webbrowsern in den frühen 1990er Jahren, was einen Dominoeffekt dramatischer Fortschritte in allen Bereichen von der Arzneimittelentwicklung bis hin zur Technologie auslösen wird.

Aber auch innerhalb der Abteilung Viele werden von der Angst verzehrt, ein gefährliches Tier freizulassen. Tatsächlich gibt es bereits generative KI Ein Instrument der Desinformation. Bald könnte es viele Arbeitsplätze gefährden.. Wenn wir so weitermachen, kann es sogar zu einer Gefahr für die Menschheit werden, ein sehr besorgniserregender Punkt.

„Ich sehe keine Möglichkeit, böswillige Akteure daran zu hindern, damit Schaden anzurichtenNotizen von Hinton.

Im März während der Eröffnung OpenAI Veröffentlicht eine neue Ausgabe von San Francisco ChatGPTMehr als 1.000 technische Führungskräfte und Forscher, darunter Elon Musk, unterzeichneten einen offenen Brief, in dem sie ein sechsmonatiges Einfrieren der Entwicklung neuer Systeme forderten. „Wegen der tiefgreifenden Risiken, die KI-Technologien für die Menschheit darstellen.“

Einige Tage später die 19 aktuellen und ehemaligen Präsidenten der Association for the Advancement of Artificial Intelligence, einer 40 Jahre alten internationalen akademischen Vereinigung. einen eigenen offenen Brief veröffentlicht, der vor den Gefahren der KI warnt. Einer der Unterzeichner Erich HorwitzDer leitende Wissenschaftler von Microsoft hat die von OpenAI entwickelte Technologie in viele seiner Produkte und Dienste eingeführt, einschließlich seiner Bing-Suchmaschine.

Hinton, wie oft genannt „Vater der künstlichen Intelligenz“Er hat keinen dieser Briefe unterschrieben, weil er Google und andere Unternehmen nicht öffentlich kritisieren wollte, bevor er seinen Job aufgab. Er kündigte seinen Abgang bei Google im vergangenen Monat an und sprach am vergangenen Donnerstag telefonisch mit ihm Google-CEO, CEO von Googles Mutterkonzern Alphabet. Hinton zog es vor, Einzelheiten seines Gesprächs mit dem Manager nicht preiszugeben.

Chefwissenschaftler von Google Jeff DeanIn einer Erklärung: „Wir sind entschlossen Ein verantwortungsvoller Umgang mit KIUnd wir forschen weiter, um die Risiken zu verstehen, die entstehen, wenn innovative Kühnheit nicht aufgegeben wird.

Hinton, heute ein 75-jähriger britischer Expatriate, ist ein lebenslanger Pädagoge, der von seinen persönlichen Überzeugungen über die Entwicklung und Nutzung von KI angetrieben wird. 1972 übernahm Hinton als Doktorand an der University of Edinburgh das Konzept eines „neuronalen Netzwerks“, eines mathematischen Systems, das Fähigkeiten durch die Analyse von Daten lernt. Nur wenige Forscher akzeptierten seine Idee, aber Hinton machte sie zu seinem Lebenswerk.

In den 1980er Jahren verließ Hinton seinen Posten, um Informatik an der Carnegie Mellon University zu lehren, und zog nach Kanada. Nicht bereit, Mittel vom Pentagon zu erhalten: Damals wurde der größte Teil der KI-Forschung in den USA vom Verteidigungsministerium finanziert. Hinton lehnt den Einsatz von iA auf dem Schlachtfeld entschieden ab: was er nennt „Robotersoldaten“.

Im Jahr 2012 bauten Hinton und seine Doktoranden Ilya Sutzkever und Alex Kryshevsky aus Toronto ein neuronales Netzwerk, das Tausende von Fotos analysieren und lernen konnte, gewöhnliche Objekte wie Blumen, Hunde und Autos zu erkennen.

Google zahlte 44 Millionen US-Dollar, um das von Hinton und zwei seiner Studenten gegründete Unternehmen zu kaufen, und das von ihnen gebaute System führte zur Entdeckung leistungsfähigerer Technologien, einschließlich neuer Chatbots. Chutskever wurde Chief Scientist von OpenAI. 2018 erhielten Hinton und ein weiterer seiner beiden langjährigen Mitarbeiter den Turing Award, „Nobelpreis für Informatik“Für seine Arbeit über neuronale Netze.

Gleichzeitig begannen Google, OpenAI und andere Unternehmen mit dem Aufbau neuronaler Netze, die durch die Verarbeitung großer Mengen digitalen Textes lernen können. Es schien Hinton, dass dies ein mächtiger Mechanismus für Maschinen war, um Sprache zu verstehen und zu produzieren, aber dass er der Art und Weise, wie Menschen Sprache manipulieren, unterlegen war.

Aber letztes Jahr Als Google und OpenAI Systeme entwickelten, die große Datenmengen verwenden, änderte sich ihre Wahrnehmung. Er glaubte weiterhin, dass Systeme dem menschlichen Gehirn in gewisser Weise unterlegen seien, aber er erkannte, dass sie in anderer Hinsicht der menschlichen Intelligenz überlegen waren. „Vielleicht ist das, was in diesen Systemen vor sich geht, viel besser als das, was im Gehirn vor sich geht.“

Und je besser die Systeme werden, desto gefährlicher werden sie. „Denken Sie daran, wie es vor fünf Jahren war und wie es jetzt ist“, sagt Hinton. „Wenn Sie diese Zeitleiste nehmen und diese Dynamik nach vorne projizieren, ist es beängstigend.“

Bis letztes Jahr fungierte Google als „perfekter Wächter“ dieser Technologie und achtete darauf, nichts Schädliches freizusetzen, sagt Hinton. Aber jetzt, da Microsoft seine Bing-Suchmaschine mit einem Conversational Bot ausgestattet hat, was offensichtlich gegen das Kerngeschäft von Google verstößt, versucht Google, die gleiche Art von Technologie zu implementieren. Tech-Giganten befinden sich in einem unaufhaltsamen Rennen, warnt Hinton.

Seine unmittelbare Sorge ist Das Internet wird mit falschen Fotos, Videos und Texten überschwemmt, und der Durchschnittsmensch „kann nicht mehr sagen, was echt ist“.

Er macht sich Sorgen um die Zeit KI revolutioniert den Arbeitsmarkt. Heutzutage ergänzen Bots wie ChatGPT häufig die menschliche Arbeit, könnten aber letztendlich Verwaltungsangestellte und diejenigen ersetzen, die routinemäßige Schreibtischaufgaben erledigen. „Es nimmt dir den schwersten Schlaf, aber es nimmt dir alles ab“, sagt Hinton.

Hinton befürchtet, dass sich zukünftige Versionen dieser Technologie ändern werden Eine Bedrohung für die Menschheit, weil sie aus den großen Datenmengen, die sie analysieren, unerwartete Verhaltensweisen lernen. Dies sei ein echtes Problem, sagt Hinton, da Unternehmen und Nutzer KI-Systemen erlauben, nicht nur ihren eigenen Computercode zu erstellen, sondern ihn auch selbst auszuführen. Hinton fürchtet das eines Tages Wirklich autonome Waffen, diese Killerroboter, werden Realität.

„Sehr wenige dachten, dass diese Dinge tatsächlich klüger sein könnten als Menschen“, sagt Hinton. „Die meisten von uns, mich eingeschlossen, dachten, es sei noch ein langer Weg. Ich dachte, es sei 30 oder 50 Jahre entfernt. Offensichtlich glaube ich das nicht mehr.“

Viele Experten, einschließlich seiner Studenten und Kollegen, sagen, die Bedrohung sei imaginär, aber Hinton glaubt, dass der Wettbewerb zwischen Google und Microsoft und anderen zu einem globalen Wettlauf werden wird, der nicht aufhören wird, bis es eine Art globale Regulierung gibt.

Leider, sagt Hinton, ist das unmöglich, weil Wie bei Atomwaffen gibt es keine Möglichkeit zu wissen, ob Unternehmen oder Länder die Technologie heimlich entwickeln. Die beste Hoffnung ist, dass die weltweit führenden Wissenschaftler auf verschiedene Weise zusammenarbeiten, um die Technologie zu kontrollieren. „Ich denke nicht, dass sie weiter gehen sollten, bis sie verstehen, ob sie es kontrollieren können“, sagt er.

Auf die Frage, wie er an der Entwicklung gefährlicher Technologien arbeiten könne, antwortete Hinton, indem er Robert Oppenheimer paraphrasierte, der das Programm zur Entwicklung der Atombombe in den Vereinigten Staaten leitete: „Wenn Sie etwas finden, das technisch unvermeidbar ist, machen Sie weiter Tu es.“

Heute nicht dasselbe sagen.

Von Kate Metz

Übersetzung von Jaime Arrambide

Die New York Times

„Professioneller Twitter-Liebhaber. Musikfan. Zombie-Guru. Unheilbarer Bacon-Fan. Organisator. Reise-Fan. Amateur-Web-Experte.“

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/6TZUQCMV24GKFG4NILG4P5K55Y.jpg)

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/RJ6LAFD7KRFIDFYPTEXSM2TCIE.jpg)

:quality(85)/cloudfront-us-east-1.images.arcpublishing.com/infobae/BWDKQ3Q6AZBBFLEC7BQ25CNXU4.png)

More Stories

Warum nicht High-Speed-Audios auf WhatsApp hören?

WhatsApp und Kalender: Ein Begleiter, mit dem Sie sich über Ihr Mobiltelefon an Ihre Arzttermine erinnern können

So erhalten Sie neue animierte Emojis auf WhatsApp